ニュース

Huawei が韓国で超低価格の1TBのSSDを32ドルで発売

消費者向けストレージ市場に変革をもたらす可能性のある驚きの動きとして、 Huawei は韓国で eKitStore Extreme 200E シリーズSSDを発表し、1TBモデルを47,500ウォン(32米ドル)という驚くべき低価格で提供開始しました。この積極的な価格戦略は、サーバーストレージソリューションでの実績に続く、 Huawei の消費者向けSSD市場への本格参入を示すものです。製品仕様とパフォーマンスeKitStore Extreme 200E シリーズは、2024年6月に発売される Huawei 初の消費者向けストレージソリューションです。このドライブは PCIe 4.0 技術を採用し、最大読み取り速度7,400 MB/s、書き込み速度6,700 MB/sという印象的な性能を実現しています。これらの速度は PCIe 4.0 ドライブとしては高性能である一方、最大14,000 MB/sを達成できる新しい PCIe 5.0 SSDと比べると控えめな数値となっています。製品仕様:容量範囲:512GB から 4TBインターフェース:PCIe 4.0読み取り速度:最大 7,400 MB/s書き込み速度:最大 6,700 MB/sNANDタイプ:QLCDRAM:なし価格(1TBモデル):47,500ウォン(約32米ドル)技術アーキテクチャeKitStore Extreme 200E の内部アーキテクチャは、QLC方式のNANDフラッシュメモリを採用し、DRAMキャッシュなしで動作します。 Huawei に対する米国の制裁が継続していることから、同社はコンポーネントを中国国内で調達している可能性が高いと考えられます。コントローラーは、低価格ドライブで人気の MaxioTech 製か、あるいはサーバーSSDコントローラーでの経験を活かした Huawei 独自設計のものである可能性があります。NANDフラッシュメモリは、中国の主要メーカーである YMTC から調達されている可能性があります。市場ポジショニングと価値提案512GBから4TBまでの容量を展開する中、1TBモデルに対する Huawei の積極的な価格戦略は、ストレージ市場に新たな基準を設定しています。32米ドルという価格は、基本的なストレージソリューションの価格帯で PCIe 4.0 の性能を提供することで、競合他社を大きく下回っています。ただし、この価格戦略の持続可能性や、一時的なプロモーション価格なのか長期的な市場ポジションなのかについては疑問が残ります。販売状況と市場への影響現在、このドライブの販売は韓国市場に限定されているようです。この地域限定での発売は、 Huawei のより広範な消費者向けストレージ事業への野心をテストする場として機能する可能性がありますが、継続中の貿易制限により国際展開については不透明な状況です。この前例のない価格設定は、競合他社に同等製品の価格戦略の見直しを迫る可能性があり、SSD市場に大きな影響を与える可能性があります。

ストレージ

2 時間前

Snapdragon 8 Elite 2 、2025年10月初旬に TSMC 3nmプロセスで登場へ

4 時間前

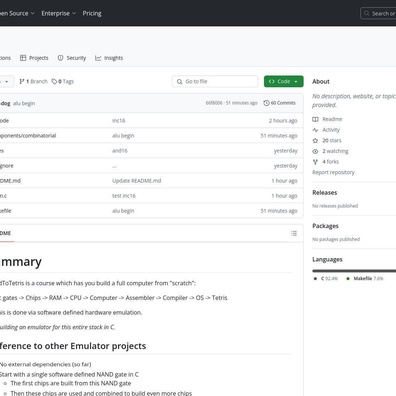

基本論理ゲートからコンピュータを構築する NandToTetris プロジェクト

4 時間前

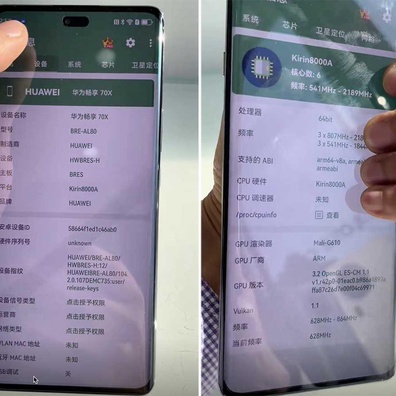

Huawei Enjoy 70X が1月3日発売決定:Kirin 8000A と衛星通信機能を搭載

スマホ

5 時間前

iQOO Z9 Turbo エンデュランスエディション:6,400mAhバッテリーとGPSアップグレードを搭載して登場

スマホ

7 時間前

EUのUSB-C規制により、Apple が29カ国でiPhone 14とSEの販売を停止

スマホ

8 時間前

Spotify でアーティスト検索時に不適切な動画が表示される、コンテンツモデレーションの失態が明らかに

アプリ

9 時間前

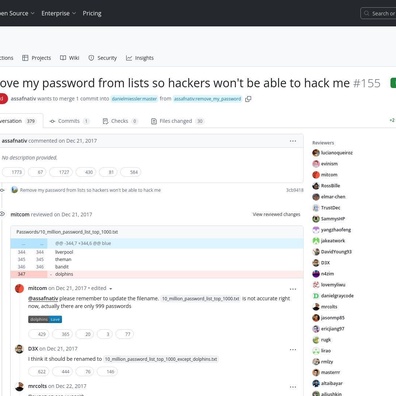

GitHub のプルリクエストが話題に:ハッキング防止のためパスワードリストからの削除を要求したユーザー

セキュリティ

16 時間前

インデックスフリー検索ライブラリが性能と簡素化のトレードオフに関する議論を呼ぶ

16 時間前

Racket で新しい画像埋め込みソリューションがテキストとバイナリファイル形式の架け橋に

AI

16 時間前

Samsung Galaxy S25 Ultra のカメラスペックがリーク:超広角カメラのみが大幅アップグレード

スマホ

23 時間前

Google、 Gemini の2025年目標を5億ユーザーに設定

AI

23 時間前

Google が検索の AI 概要に Gemini 風の新しいローディングアニメーションをテスト中

AI

昨日

iPhone 16 Pro レビュー:2024年の主要アップグレードと必須アクセサリー

スマホ

昨日

T-Mobile の Starlink 衛星メッセージングベータ版、間もなくローンチの兆し

アプリ

昨日

Honor Magic V3 が2024年最高の折りたたみスマートフォンに選出:超薄型デザインで新基準を確立

スマホ

昨日

Meta Quest のソフトウェアアップデートによる年末年始の大規模な機器障害が発生

Meta

昨日

OnePlus Open 2 のリーク情報、より薄型のデザインと性能向上が明らかに

スマホ

昨日

Windows ユーザーに朗報: KDE スタイルのウィンドウ管理を実現する Resizer2 が登場

アプリ

昨日

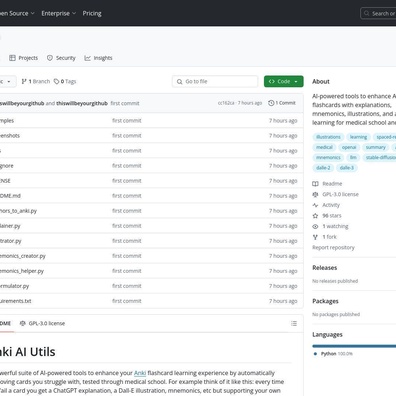

AIで強化された Anki ツールが創造的な記憶ソリューションを生み出す:記憶術から音楽まで

AI

昨日