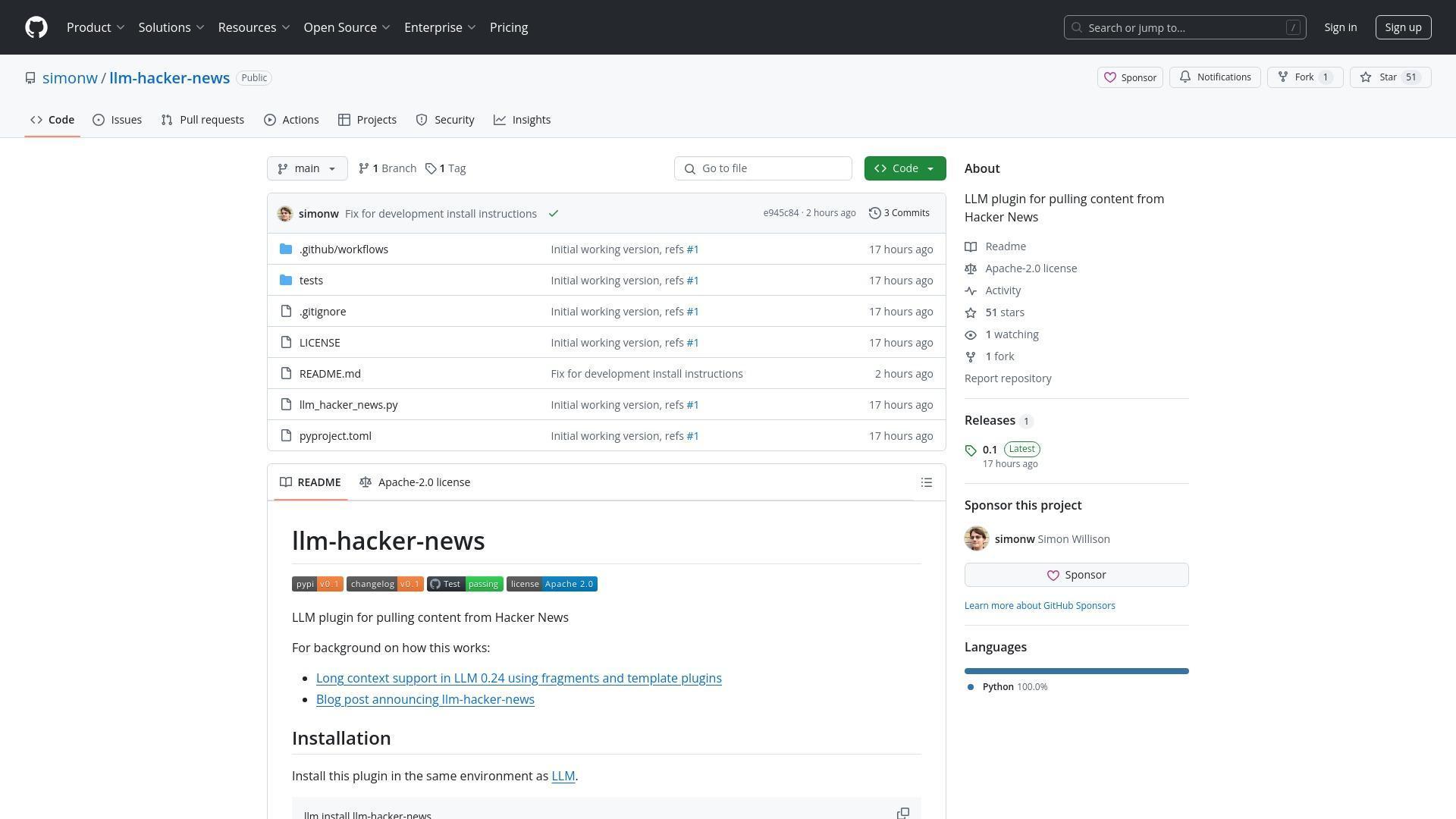

Simon Willison は最近、彼のコマンドライン LLM ツール向けの新しいプラグイン「llm-hacker-news」をリリースしました。これは Hacker News のディスカッションからコンテンツを取得し、大規模言語モデルに直接フィードするように設計されています。この技術的成果は多くの人に感銘を与えましたが、同時にデータプライバシー、同意、そして公開フォーラムのコンテンツを AI 処理に使用する倫理についての重要な議論も引き起こしました。

技術的革新

llm-hacker-news プラグインは、Willison が彼の LLM コマンドラインツールに追加した新しいフラグメント機能を基盤としています。この機能により、ユーザーは Gemini や Llama 4 のような大規模言語モデルに長文コンテキストを簡単に送ることができます。このプラグインは特に、シンプルなコマンド構文を使用して Hacker News のディスカッションスレッド全体を取得することを可能にします:

llm -f hn:43615912 'summary with illustrative direct quotes'

このプラグインは Hacker News API からデータを取得し、LLM フレンドリーなテキスト形式に変換して、ユーザーが設定したデフォルトモデル(gpt-4o-mini など)に送信します。これにより、手動でのコピー&ペーストなしに、オンラインディスカッションの分析と要約のプロセスが効率化されます。

llm-hacker-newsプラグインの主な特徴:

- 項目IDを使用してHacker Newsのスレッド全体を取得可能

- LLMコマンドラインツールの新機能「fragments」に基づいて構築

- Algolia JSON APIを使用してコンテンツを取得

- HNコンテンツをLLMフレンドリーなテキスト形式に変換

- GPT-4o-mini、 Claude 、 Gemini など様々なLLMモデルと連携可能

インストールと使用方法:

llm install llm-hacker-news

llm -f hn:43615912 'summary with illustrative direct quotes'

関連するコミュニティの懸念事項:

- コンテンツ処理におけるデータプライバシーと同意

- 利用規約の遵守

- 人間による読み取りとアルゴリズムによる処理の区別

- AI駆動型インターネットにおけるコンテンツ所有権の将来

プライバシーの懸念と同意

このリリースは、ユーザーが自分のフォーラム投稿が LLM によって処理されることをオプトアウトできるべきかどうかについて熱い議論を引き起こしました。あるユーザーは直接尋ねました:私の会話が LLM に送られることをオプトアウトする方法はありますか?この質問は、コンテンツのスクレイピングと使用権に関する懸念の高まりを反映しています。

「ここでの懸念は、LLM の寄生者が他の人々の仕事から金儲けをするスキームのために、彼らの帯域幅、つまり彼らのお金を無駄にしていることに人々が満足していないということです。」

Willison はコピー&ペースト操作を防ぐことの実質的な不可能性を指摘し、たとえそのような制限が存在したとしても、スクリーンショットがそれを回避できると述べました。また、OpenAI や Anthropic のように API 経由で送信されたコンテンツでトレーニングを行わないプロバイダーもあれば、Gemini のように無料ティアユーザーからのデータを製品改善に使用する可能性があるプロバイダーもあるという、LLM トレーニングポリシーの複雑な状況も強調しました。

法的・倫理的境界

複数のコメンターが、このプラグインが Hacker News の利用規約に違反しているかどうかについて疑問を提起しました。利用規約ではスクレイピングやデータ収集が禁止されています。あるユーザーは特に HN のガイドラインを引用しました:「Y Combinator によって明示的に許可されている場合を除き、サイトやサイトコンテンツを修正、コピー、フレーム、スクレイプ、[...] または派生物を作成しないことに同意するものとします。」

この議論は、公開アクセスとコンテンツ所有権の間の根本的な緊張関係を明らかにしました。公開フォーラムへの投稿は暗黙のうちに様々な形での消費に同意していると主張する人もいれば、人間による読み取りとアルゴリズムによる処理の間には意味のある区別があると主張する人もいました。特に、その処理が最終的に商業的な AI トレーニングデータセットに取り込まれる可能性がある場合はなおさらです。

LLM ツールの未来

論争にもかかわらず、多くのユーザーがこの技術の可能性に関心を示しました。機能拡張の要望には、HN のお気に入りトピックの要約、時間の経過に伴うディスカッションの追跡、MCP(Message Context Protocol)などの他のプロトコルとの統合が含まれていました。Willison は、彼の次の大きな LLM 機能はツールサポートになると述べ、そのフレームワークの上に MCP プラグインを構築する計画があると述べました。

また、議論はローカル LLM モデルの急速に向上する品質にも触れました。Willison は、ローカルモデルは約6ヶ月前までは使い物にならないほど弱かったが、最近では Qwen Coder 2.5、Llama 3.3 70B、Mistral Small 3、Gemma 3 などのモデルが十分な RAM を持つ消費者向けハードウェアで印象的なパフォーマンスを発揮するようになったと述べました。

llm-hacker-news プラグインは、AI ツールがオンライン体験にますます統合されるにつれて生じる、エキサイティングな技術的可能性と複雑な倫理的問題の両方を表しています。これらの技術が進化し続けるにつれて、コミュニティはイノベーションとユーザーのエージェンシーおよびコンテンツの権利を尊重することのバランスをとる必要があるでしょう。

参照: Ilm-hacker-news