機械学習のための特殊なOCR(光学式文字認識)システムの開発が、AIの信頼性、データの整合性、そして倫理的考慮に関する重要な議論を引き起こしています。複雑な教育資料から構造化データを抽出するために特別に設計された最近共有されたOCRシステムが、文書処理パイプラインにおける生成AIの利点とリスクについての微妙なコミュニティ対話の中心となっています。

|

|---|

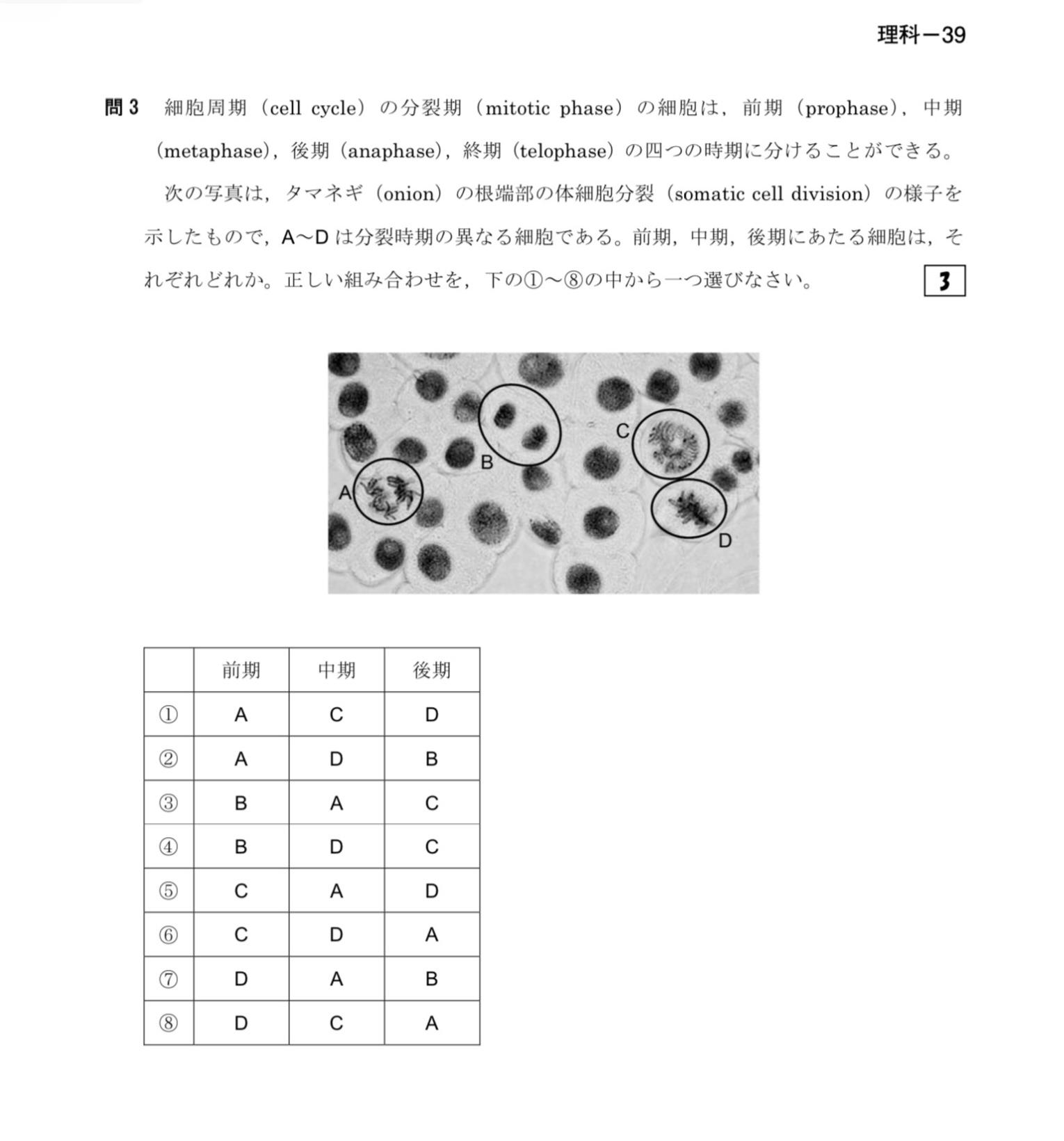

| この図は植物細胞における有糸分裂の段階を説明しており、教育資料における構造化データ抽出の重要性を強調しています |

AI強化OCRにおける幻覚の懸念

コミュニティメンバーは、OCRプロセスにおける大規模言語モデル( LLM )の使用の信頼性について重大な懸念を提起しています。主な懸念は、AIの幻覚に集中しています - モデルが本物のOCR間違いを修正するだけでなく、正確なコンテンツを誤って変更したり、完全に作り出された情報を生成したりする可能性があるということです。あるコメンテーターは、このリスクをステロイドを投与された xerox バグに例えました。これは、スキャンされた文書で数字が意図せず入れ替わるという歴史的な問題を指しますが、AIが関与するとより深刻な結果をもたらす可能性があります。

開発者はこれらの懸念を認め、従来のOCRエンジンが初期のテキスト抽出を処理し、生成AIは第二段階の改良段階でのみ適用される二段階アプローチを実装していると述べました。また、正確に抽出されたテキストの変更を防ぐための単純な検証チェックを実装していると言及しましたが、これらの安全対策の有効性はまだ徹底的に評価される必要があります。

OCRシステムの主要コンポーネント

- DocLayout-YOLO:表領域検出用

- Google Vision API:表処理と画像分析に使用

- Gemini Pro Vision:文脈を考慮した説明の生成用

- MathPix OCR:数式抽出用

- OpenCV:画像処理用

主なコミュニティの懸念事項

- OCRにLLMを使用する際のAIハルシネーションリスク

- プロンプトインジェクションの脆弱性

- ライセンスの競合(MIT対AGPL-3.0)

- トレーニングのための倫理的なデータ取得

- AI支援コミュニケーションにおける信頼性

計画された将来の改善点

- API依存なしで完全ローカル推論のサポート

- 代替オープンソースコンポーネント:

- 一般OCR用の Tesseract または TrOCR

- ドキュメント構造用の Pix2Struct、Donut、または DocTR

- 画像-テキストのセマンティックアライメント用の OpenAI CLIP

- 推論タスク用の Gemma / Phi / LLaMA / Mistral

- 強化されたセマンティック構造化モジュール

プロンプトインジェクションの脆弱性

セキュリティを重視するコメンテーターは、プロンプトインジェクションを別の潜在的なリスク領域として強調しました。 LLM が処理パイプラインの一部として機能する場合、指示と処理されるデータの間に明確な分離を維持することには固有の課題があります。これにより、文書内の悪意のあるコンテンツがシステムの動作を操作する可能性があります。

開発者は、JSONフォーマットを使用して指示とデータを分離し、サンドボックス環境でシステムを実行することでこのリスクを軽減しようとしていると回答しました。しかし、このアプローチは完璧ではないと認め、セキュリティの懸念は改善が継続的に必要な分野であることを示唆しました。

オープンソースとライセンスの質問

プロジェクトのライセンス構造も精査の対象となりました。当初は MIT ライセンスの下でリリースされましたが、コミュニティメンバーは組み込まれたコンポーネントの一部との潜在的な非互換性を指摘しました - 特に、より制限的な AGPL-3.0 ライセンスを使用する DocLayout-YOLO モデルです。これは、AIハイブリッドシステムが、特に異なる要件を持つ複数のオープンソースコンポーネントを組み合わせる際に、ナビゲートしなければならない複雑なライセンス環境を強調しています。

開発者はこのライセンスの衝突に驚いた様子で、この見落としを速やかに認め、ライセンス要件をより注意深く見直すことを約束しました - これは、開発者がAIシステム開発の法的側面を適切に管理する上で直面する課題を示しています。

言語翻訳とコミュニケーションの課題

コミュニティコメントへの回答を作成するために開発者が LLM を使用していることについて、興味深いメタディスカッションが浮上しました。不自然に洗練された文体について質問されたとき、開発者は自分が19歳の韓国人学生で、英語でより明確にコミュニケーションするためにAIの支援を使用していることを明らかにしました。これにより、コミュニケーション補助としてのAIの使用の正当性と個人的な表現の真正性の維持についての幅広い会話が始まりました。

一部のコミュニティメンバーは、このユースケースを完全に合理的なものとして擁護し、コミュニケーションを強化するためにキーボードやスペルチェッカーを使用することに例えましたが、他のメンバーはAIを介したコミュニケーションによるオンライン言説の均質化の増加について懸念を表明しました。

機械学習におけるOCRの将来の方向性

懸念にもかかわらず、多くのコメンテーターはプロジェクトの核心的な目標の価値を認識しました:複雑な文書から構造化情報を抽出することで機械学習のためのトレーニングデータの質を向上させることです。あるコメンテーターは、抽出されたデータを一貫性があり、意味的に有意義な構造に整理することが高品質なMLトレーニングにとって重要であると強調し、基本的なレイアウト分析を超えた意味的構造化がMLトレーニングパイプラインでOCRデータの価値を最大化するための次のフロンティアであることを示唆しました。

開発者はこの方向にシステムの能力を拡張する計画を示し、階層的表現を構築し、文書セクション間のエンティティ関係を識別するためのモジュールを追加することを述べました。

AIが文書処理ワークフローにさらに統合されるにつれて、このOCRシステムを巡るコミュニティディスカッションは、AIの能力を活用することとデータの整合性、セキュリティ、倫理的使用に関する正当な懸念に対処することとの間の微妙なバランスを開発者が取らなければならないことを強調しています。この対話は、AIツールのオープンな共有が、最終的に誰にとってもテクノロジーを向上させる貴重なコミュニティフィードバックにつながる方法を示しています。

参照: 機械学習のために最適化されたOCRシステム:図、図表、表、数式、多言語テキスト

|

|---|

| 構造化された視覚データの表現は、機械学習のトレーニングデータの品質を向上させるために不可欠です |